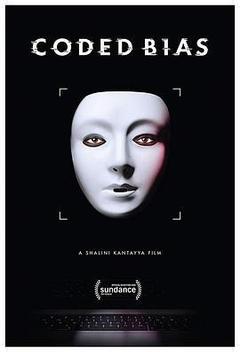

Exploring the fallout of MIT Media Lab researcher Joy Buolamwini’s startling discovery that facial recognition does not see dark-skinned faces accurately, and her journey to push for the first-ever legislation in the U.S. to govern against bias in the alg[展开全部]

Exploring the fallout of MIT Media Lab researcher Joy Buolamwini’s startling discovery that facial recognition does not see dark-skinned faces accurately, and her journey to push for the first-ever legislation in the U.S. to govern against bias in the algorithms that impact us all.第36届圣丹斯电影节评审团大奖 纪录片(提名)Shalini Kantayya《编码歧视》下载观后评论:此片充分展现了美英自由主义进步政治、多元化、国内种族正义斗争,与他者化中国/中国人的并行并举。从刻意的无厘头中文翻译(只为表明这是“中国”),到对中国制度的想当然,到采访这唯一一个惊世骇俗的奇葩中国人(号称要感谢信用积分帮助她有效择友)——纪录片最后,美国英雄说,他们和全球反监视斗士站在一起,胜利属于他们。这就很清楚了,“中国”对于这个纪录片的主体而言,一开始就在这场斗争之外。一开始就是他者。一开始就没有相应的人性。是反乌托邦的平行宇宙。用来侧目,用来酝酿,用来自我鞭策。这其实也都无所谓——如果中国不是一个真实的地方,中美关系不是真实的地缘政治,中国人不是血肉的行在这个地球的人。"What it means to be human is to be vulnerable.Being vulnerable, there is more of a capacity for empathy, there is more of a capacity for compassion.If there is a way we can think about that within our technology.I think it would reorient the sorts of questions we ask."在没接触相关的学术探讨之前可能会觉得这部片子角度新颖,现在会觉得只是记录了几个主人公为发声作出的努力,在引导大众重新审视“人脸识别”/AI/算法技术上没有推进。我在想,也许目前传统纪录片形式并不适合去表达这个话题,因为观众已经适应了这个环境,需要更大的“刺激”才能激发辩证思考,形式创新尤为重要。比如互动纪录片Do Not Track,multimedia project Stealing UR Feelings就用更简短的篇幅和互动形式让观众自发地意识到目前算法技术的问题。一个个鲜活的人被算法赋予价值,连AI都学会了歧视,直到今天2020.09.05 依然没有出台任何关于限制人脸识别的算法。以及有点讽刺的是 我边喝着靠着人脸识别支付的奶茶边看着大屏幕上打出一行“San Francisco became the first city to ban the facial recognition system” 两个国家全然两个极端刚好学校和校际有看的机会,再加上明天要和同事给学生准备一个这个纪录片的讨论空间,就和家属一起看了。内容是不错,有点浅,但也没办法,倒是里面有采访的对象在Twitter上的分享更有意义(比如:)data ethics和algorithm bias在不久的今后肯定会进入统计和数据科学的教学内容和空间,所以我等也需要多进行自我教育努力思考形成观点… 无法评分。一方面是跟我感兴趣的话题很相关的讨论,一方面觉得导演也只是生产了一个纪录片流水线产物,只不过perspective比较有意思。看片高潮在看完片之后,which is when danah boyd is answering my questionnn!!! 我追到星了!(暴言)但凡学点皮毛就知道现在的ml models有多么的不靠谱,现有的datasets都是一堆historical ??做成这样他们也敢拿出来卖钱我也是真心服了…不过光看accuracy precision/recall F1 MSE的时代也已经过去了,victory is ours.科幻片中的世界已经到来,只是尚未平均地实现在所有人身上。而更糟糕的是,现实是反着来的,更以效率而非道德为准的算法,会先作用在社会底层的人们,在不知不觉中,将你分级分类。而这以科技发展为名的趋势,目前却毫无对其有力监管监督的机构...提出了值得探索的观点,以及适当的话题兴趣,尚可一看。但短短时间内,受访者与镜头开始不断飘摇,别国、AI、数据隐私、新闻事件...一篮子装,就想法太多角度太乱;这些提出最终没有归拢到问题本身,比较可惜,也值得更多挖掘。对于专业学习者来说没什么新意,意义在于面向公众讲得还算清楚。有时候分不清中国人对于算法社会的理解模糊究竟是好是坏,至少片中是被当作民主的对立面展示的。即使以新的特色方式加以监管,恐怕也将会是历时数十年的共业。有讲到big bro is watching you 然后用了一些泥岗去年下半年的footage 很update了 然而字幕打出来 还是难以避免后面跟着逗号柴纳 忍不住想泥岗观众如果见到又该不开心了吧看完感觉讨论的不是人工智能,而是权力边界的问题,以及隐私保护。里面提到了不少算法的偏见,以及错误判断,我想问的是:如果存在一个100%正确的算法,它是否就可以合理搜集和获取所有的信息?有关算法偏见在面孔识别,治安,教育,法律等领域的讨论。有趣的是研究算法偏见和推动立法的主角是一色的女性研究者,和social dilemma里面负责产品技术的白男形成了鲜明对比。[收起部分]